Autonomes Fahren, also das selbstständige Fahren eines Autos ohne menschliches Eingreifen, ist ein Traum vieler Menschen und hat in den vergangenen Jahren immense Fortschritte gemacht. Es kann die Art und Weise verändern, wie wir uns von A nach B bewegen. Autonome Fahrzeuge bieten eine Vielzahl von Vorteilen wie erhöhte Sicherheit, bessere Effizienz und eine bequemere Fahrt. In diesem Artikel werden wir uns genauer mit der Technologie des autonomen Fahrens beschäftigen und herausfinden, wie autonomes Fahren funktioniert und welche Herausforderungen es gibt.

Diesen und andere Beiträge von mir kannst du als sauber formatierte PDF-Datei zum Ausdrucken oder offline Lesen erwerben. Mehr Informationen dazu findest du hier.

Zu diesem Artikel findest du auch ein Video von mir auf YouTube.

Autonomes Fahren – Eingliederung in verschiedene Level

Je nachdem, wie weit sich ein Fahrzeug selbstständig im Straßenverkehr bewegen kann, wird es unterschiedlichen Automatisierungsgraden zugeordnet. Zu den ersten drei Level gehören Fahrzeuge mit lediglich unterstützenden Fahrfunktionen. Erst ab Level 3 gilt ein Fahrzeug als autonom.

Ein „Level 0“-Fahrzeug ist ein Fahrzeug ohne jegliche Automatisierung, das heißt, der Fahrer muss alle Aufgaben selbst übernehmen. Auf „Level 1“ ist ein Fahrzeug, welches bereits unterschiedliche Assistenzfunktionen unterstützt, wie die automatische Abstandskontrolle. Teilautomatisierte Fahrzeuge auf „Level 2“ übernehmen bereits kleinere Aufgaben im Straßenverkehr, wie ein Spurhalteassistent oder ein Stauassistent.

In den folgenden drei Leveln wird im unterschiedlichen Ausmaß die gesamte Fahrzeugführung vom Fahrzeug übernommen. Auf „Level 3“ fährt das Fahrzeug in bestimmten Umgebungen selbst und muss nicht dauerhaft durch den Fahrer überwacht werden. Jedoch kann das Fahrzeug zu jedem Zeitpunkt mit einer gewissen Vorwarnzeit den Fahrer zur Übernahme des Fahrzeugs auffordern. Audi behauptet den ersten Serienwagen mit einer „Level 3“-Automatisierung entwickelt zu haben, allerdings nur unter eingeschränkten Bedingungen auf der Autobahn.

Auch „Level 4“-Fahrzeuge können nur in speziellen Anwendungsfällen operieren, jedoch ist in diesem Falle ein Eingreifen des Fahrers definitiv nicht erforderlich. Ein voll automatisiertes Fahrzeugsystem auf „Level 5“ kann in jeder Umgebung, auf jeder Straße und unter jeglichen Wetterbedingungen eigenhändig fahren. Bis heute hat jedoch kein Hersteller ein Serienfahrzeug mit Level Vier oder Fünf Fahrfunktionen auf die Straße gebracht. Der Leiter des Toyota-Research-Institute gibt sogar an, dass die Industrie dem Ziel eines „Level 5“-Fahrzeugs noch nicht einmal nahe ist.2 Die Aussage ist zwar schon etwa 5 Jahre alt, dennoch ist sie meines Erachtens weiterhin gültig.

Hard- und Softwarekomponenten

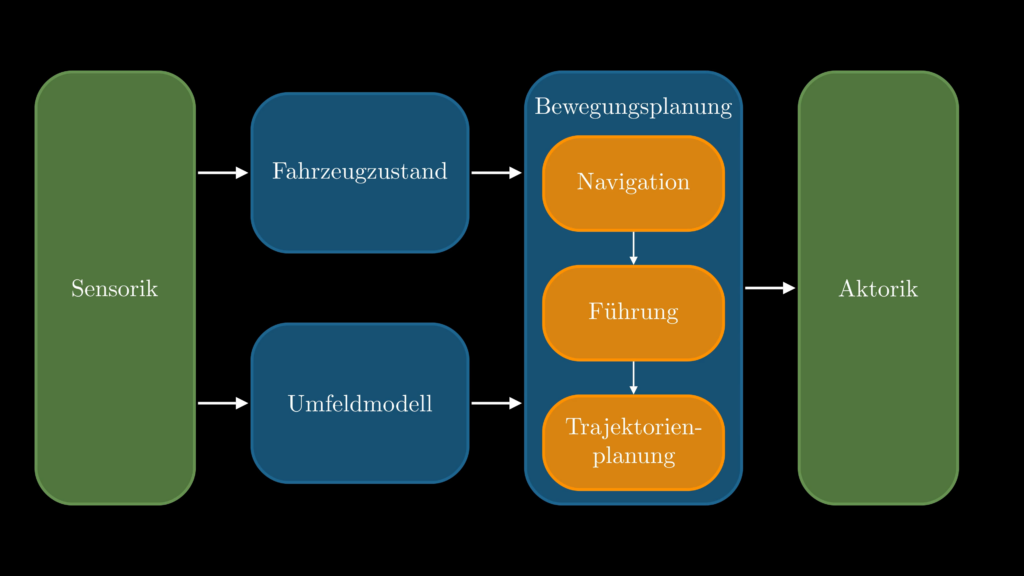

Schauen wir uns nun einmal an, wie ein solches autonomes Fahrzeug im groben aufgebaut ist und wie die Hard- und Softwarekomponenten miteinander interagieren. Zunächst wird die Umgebung mit der Hilfe von Sensoren gescannt. Aus den gewonnenen Sensordaten wird dann sowohl der aktuelle Zustand des Fahrzeugs ermittelt, als auch ein Umfeldmodell erstellt. Diese Daten sind der Input für die Bewegungsplanung, welche in mehrere Unterkomponenten gegliedert ist, die aufeinander aufbauen: Navigation, Führung und schließlich die Trajektorienplanung. Abschließend gehen die Daten aus der Bewegungsplanung in die Aktorik, welche das Fahrzeug steuert.

Die obige Darstellung ist etwas vereinfacht und im Detail gibt es deutlich mehr Komponenten. Für einen groben Überblick und um den Datenfluss innerhalb eines autonomen Fahrzeugs zu verstehen, ist diese Darstellung aber ausreichend. Im Folgenden schauen wir uns die eben genannten Hard- und Softwarekomponenten einmal genauer an.

Sensoren

Der Mensch nimmt den Straßenverkehr zum größten Teil durch seine Augen wahr. Für ein autonomes Fahrzeug sind dies die Sensoren, mit denen er die Umgebung und den eigenen Fahrzeugzustand wahrnimmt. Schauen wir uns also einmal an, welche Sensoren in so einem autonomen Fahrzeug alles verbaut sind. Es gibt natürlich sehr unterschiedliche Sensorsetups, ich stelle hier einmal beispielhaft eine mögliche Variante vor.4

An der Front des Fahrzeugs ist ein sogenannter Long-Range Radar verbaut, der mittels elektromagnetischer Wellen Objekte, zum Beispiel andere Fahrzeuge und Fußgänger, erfasst und deren Abstand zum Fahrzeug sowie deren Relativgeschwindigkeiten misst. Solch ein Radarsensor hat dabei eine Reichweite von bis zu $250m$.

Weiterhin gibt es Short-Range Radare an der Front, am Heck und an der Seite des Fahrzeugs mit der gleichen Aufgabe. Diese haben eine geringere Reichweite bis zu etwa $24 m$, haben dafür aber einen größeren Abstrahlwinkel. Zudem arbeiten sie in einem anderen Frequenzbereich.

Beispielhaft sei hier einmal eine Szene aus dem Straßenverkehr gezeigt, die Daten aus einem Radar visualisiert.

Weiterhin befinden sich in einem autonomen Fahrzeug eine Vielzahl von Kameras, in der unteren Abbildung einmal exemplarisch durch eine Kamera in jede Richtung dargestellt.

Kameras erstellen hochauflösende Bilder der Umgebung und detektieren dabei statische und dynamische Objekte. Statische Objekte sind stillstehende Objekte wie Straßenschilder, Ampeln oder Fahrbahnmarkierungen. Dynamische Objekte hingegen sind sich bewegende Objekte wie andere Fahrzeuge oder Fußgänger. Mit der entsprechenden Software, die häufig auf Machine Learning basiert, können diese Objekte detektiert und klassifiziert werden.

Ein weiterer häufig verwendeter Sensortyp ist der LiDAR, wobei LiDAR die Abkürzung für „Light Detection and Ranging“ ist. Wie der Radarsensor auch sendet der LiDAR-Sensor elektromagnetische Wellen aus, allerdings in einem anderen Frequenzbereich. Der LiDAR ist im Gegensatz zum Radar in der Lage, einzelne Punkte im Umfeld abzutasten und so entstehen dreidimensionale Punktwolken, welche die Umgebung mit höherer Auflösung repräsentiert, als ein Radarbild. Dadurch können komplexe Objekte abgebildet und etwa einen Fußgänger von einem Auto unterschieden werden.

Beispielhaft ist hier auch einmal ein kurzer Ausschnitt aus der Visualisierung eines Lidar im Straßenverkehr gezeigt.

Rundum um das Fahrzeug werden Ultraschallsensoren für die Detektion im Nahbereich eingesetzt. Sie sind insbesondere bei Einparkhilfen oder dem selbstständigen Einparken des Fahrzeugs im Einsatz. Ihre Reichweite ist mit etwa $5.5m$ jedoch stark begrenzt.

Letztlich gibt es dann noch die IMU, die innerhalb des Fahrzeugs verbaut ist. IMU steht für „Inertial Measurement Unit“ und dient zur exakten Messung der Eigenbewegung des Fahrzeugs. Dazu gehören etwa die Beschleunigung und die Drehrate des Fahrzeugs. Zudem können die Daten aus der IMU mit den GPS-Daten fusioniert werden, um eine genauere Positionsbestimmung, im Fachjargon Lokalisierung genannt, vornehmen zu können.

Fahrzeugzustand

Zum Fahrzeugzustand zählen die aktuelle Geschwindigkeit, Beschleunigung, Orientierung und noch einiges mehr. Die meisten dieser Daten lassen sich relativ leicht und präzise mit fahrzeuginternen Sensoren wie der IMU messen. Eine große Herausforderung stellt jedoch die Messung der exakten Position des Fahrzeugs, also die Lokalisierung, dar.

GPS-basierte Lokalisierung

Heutzutage ist, wie in vielen technischen Geräten, in jedem Fahrzeug ein GPS-System verbaut. Solch ein GPS-System kommuniziert mit Satelliten und kann die Position auf etwa $10m$ genau bestimmen. Durch Verwendung von Differential-GPS kann eine Genauigkeit von etwa $1m$ erreicht werden. Dazu werden zusätzliche Korrekturdaten von Referenzstationen verwendet, deren Positionen exakt bekannt sind. So können Fehler herausgerechnet werden.13

Es herrscht derzeit noch keine Übereinstimmung über die Anforderungen an Genauigkeit und Verfügbarkeit einer Lokalisierung für autonome Fahrzeuge.14,15 Als Mittel kristallisiert sich jedoch etwa ein Wert von $0.2m$ heraus.16 Damit ist auch ein DGPS-System nicht genau genug, um in einem autonomen Fahrzeug sicher eingesetzt zu werden.

Mittels des RTK-Verfahrens können Genauigkeiten von bis zu $1cm$ erreicht werden. Dazu werden jedoch nicht die Codes der Satelliten, sondern die Radiowellen selbst zur Ermittlung der Entfernungen zu den jeweiligen Satelliten verwendet. Dazu wird jedoch Empfang von mindestens fünf, besser sogar von mindestens sechs Satelliten, benötigt. Das RTK-Modell ist jedoch kostenpflichtig und benötigt teures Equipment. Zudem kann es in städtischen Gebieten zu Problemen mit dem Empfang und reflektierten Signalen kommen. Dadurch wird die Genauigkeit wieder geringer. Durch Verwendung von Bewegungsdaten aus der IMU können diese Ungenauigkeiten, zumindest teilweise, wieder kompensiert werden.13

Landmarkenbasierte Lokalisierung

Eine andere Möglichkeit zur Lokalisierung, die vorwiegend in städtischen Gebieten verwendet werden kann, ist eine landmarkenbasierte Lokalisierung. Hierzu werden unbewegliche Landmarken wie Bäume oder Schilder in einer zuvor angelegten digitalen Karte hinterlegt. In früheren Jahren wurden meist LiDAR-Daten verwendet, um die gemessenen Daten und die Landmarken aus der digitalen Karte zu vergleichen. Aufgrund der großen Fortschritte in der Machine Learning basierten Erkennung von Objekten aus Kamerabildern, kommen heutzutage mehrheitlich diese Methoden zum Einsatz.

Die Genauigkeit der Landmarken-basierten Lokalisierung hängt von verschiedenen Faktoren ab, darunter die Anzahl und Qualität der verfügbaren Landmarken, der Abstand zwischen dem Fahrzeug und den Landmarken, sowie die Genauigkeit der Sensoren und Algorithmen. In Gebieten mit Signalstörungen kann diese Form der Lokalisierung genauer sein, als eine GPS gestützte Lokalisierung.17 Zudem kann auch bei der landmarkenbasierten Lokalisierung die Genauigkeit durch Verwendung von Bewegungsdaten aus der IMU verbessert werden.

Umfeldmodell

Blicken wir nun einmal auf das Umfeldmodell, welches aus den Sensordaten gewonnen wird. Wie der Name schon suggeriert, wird eine modellhafte Abbildung der Umgebung erzeugt, auf dessen Basis später die Bewegung des Fahrzeugs geplant wird.

Statische Objekte

Bei der Erstellung dieses Modells betrachten wir zunächst einmal die statischen Objekte. Dazu gehören etwa die Straße und die Fahrbahnmarkierungen. Weiterhin gehören Straßenschilder und parkende Fahrzeuge in diese Kategorie. Also alle unbeweglichen Objekte, die im Straßenverkehr auftauchen können. Dazu gehört dann zum Beispiel auch eine Mülltonne, die unachtsam auf die Straße geschoben wurde oder Pylonen, die zwecks Bauarbeiten dort platziert wurden.

Dynamische Objekte

Kommen wir jetzt zu den dynamischen Objekten. Am häufigsten anzutreffen, sind in dieser Kategorie vermutlich andere Fahrzeuge, die im Umfeld des autonomen Fahrzeugs unterwegs sind. Hinzu kommen natürlich auch Fahrradfahrer und Fußgänger. Um diese Objekte zu detektieren werden zumeist neuronale Netze in Kombination mit Kamerabildern, manchmal auch LiDAR-Daten, verwendet. Um die Objekte herum werden dann sogenannte Bounding-Boxen gezogen, deren Ausmaße und Orientierung in das Umfeldmodell einfließen.

Neben weiteren gemessenen Daten zu dem dynamischen Objekt, wie der Geschwindigkeit, wird eine Verhaltensprädiktion durchgeführt, um das zukünftige Verhalten der anderen Verkehrsteilnehmer zu ermitteln und entsprechend darauf reagieren zu können. Hier werden häufig stochastische Methoden angewendet, die jedem möglichen Manöver der anderen Fahrzeuge eine Wahrscheinlichkeit zuordnen. Diese Manöver könnten etwa Spur halten, Spur wechseln oder Abbiegen sein.

Bewegungsplanung

Kommen wir nun zum Herzstück des autonomen Fahrens, der Bewegungsplanung, welche noch einmal in viele kleinere Bereiche unterteilt ist. Betrachten wir zunächst einmal das Navigationsmodul.

Navigation

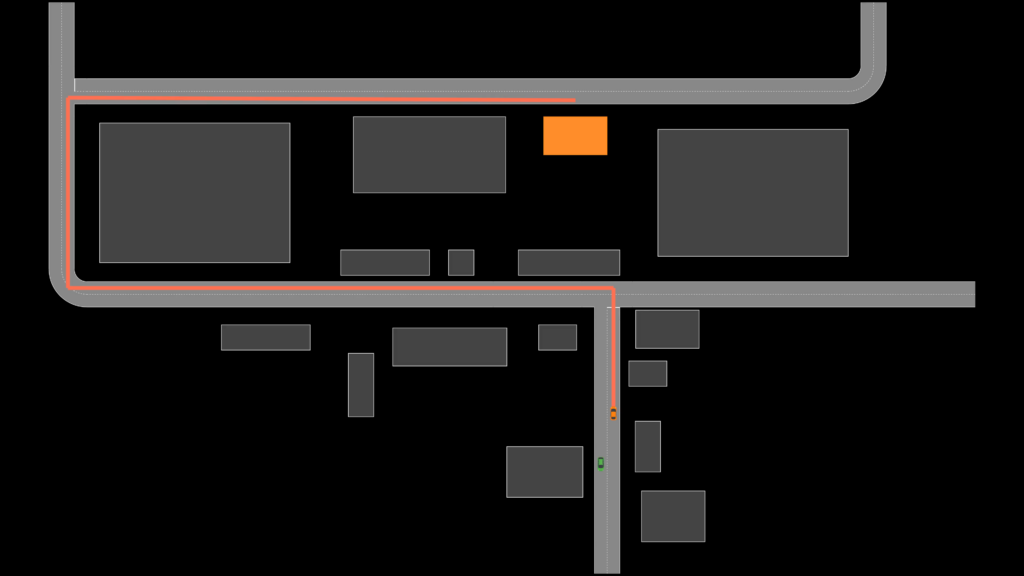

In diesem Modul wird die globale Route für das autonome Fahrzeug geplant. Es ist nichts anderes als eine Art Navigationssystem, welches die Route vom aktuellen Punkt A zu einem Punkt B berechnet. Nehmen wir in diesem Beispiel an, dass das Fahrzeug im unteren Teil der folgenden Abbildung zu dem orange markierten Haus fahren möchte.

Auf Basis dieser Informationen wird die rote Route vom Navigationsmodul geplant. Das geschieht in der Regel vor dem Fahrtantritt und kann, wie bei Google Maps, auch während des Fahrens aufgrund von Verkehrsstörungen oder anderen Zwischenfällen, jederzeit aktualisiert werden. Die Fahrt wird dann anhand der ermittelten Route durchgeführt.

Führung

Die Führung des Fahrzeugs ist sozusagen die Navigation des Fahrzeugs im lokalen Bereich. Hier wird das nächste auszuführende Manöver des Fahrzeugs ermittelt, etwa ein Abbiegevorgang nach links, wobei bei der Auswahl dieses Manövers automatisch der Blinker nach links aktiviert wird. Blicken wir einmal beispielhaft auf ein Fahrzeug, das auf ein parkendes Fahrzeug auffährt und betrachten dabei, wie eine solche Manöverauswahl in einem autonomen Fahrzeug durchgeführt werden kann.

Eine Manöverauswahl wird häufig durch eine State Machine realisiert. Dabei befindet sich das Fahrzeug in einem bestimmten State, wie dem Manöver „Straße folgen“. Treten jetzt bestimmte Faktoren auf, wie hier das voraus liegende parkende Fahrzeug, dann wird in einen anderen State gewechselt. In diesem Fall in den State „Anhalten und Warten“, denn es kommt unserem autonomen Fahrzeug ein anderes Fahrzeug entgegen.

Sobald die Straße frei ist, wechselt das autonome Fahrzeug in den State „Hindernis umfahren“ und führt dieses Fahrmanöver aus.

Da die vor dem Fahrzeug liegende Straße frei ist, wechselt das Fahrzeug wieder in den State „Straße folgen“ und führt dieses Manöver aus.

Das war jetzt natürlich nur eine kleine Darstellung einer State Machine, im realen Fahrzeug ist diese natürlich deutlich umfangreicher und mit deutlich mehr Bedingungen verknüpft, mit denen von einem in den anderen State gewechselt wird.

Trajektorienplanung

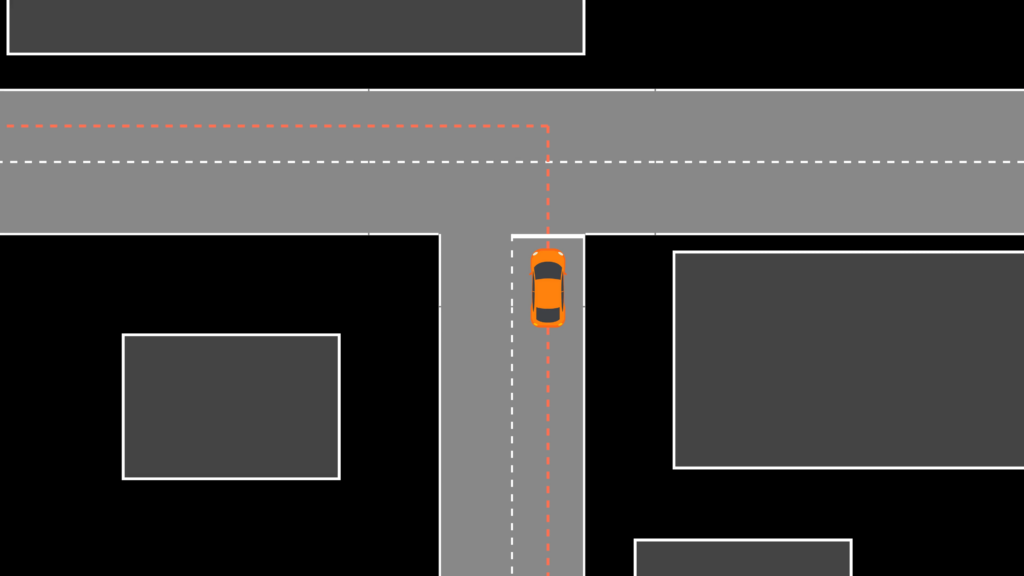

Ist ein Manöver für das Fahrzeug ausgewählt worden, so liegt es nun an der Trajektorienplanung, die exakten Bewegung des Fahrzeugs für die nächsten paar Sekunden zu planen. Betrachten wir einmal eine Situation vor einem Abbiegevorgang.

Das Fahrzeug soll der roten Führungslinie, die durch die Navigation erstellt wurde, folgen. Häufig wird diese Linie als Referenzpfad genutzt, an der sich die Trajektorienplanung orientiert. Zudem wird durch die Manöverauswahl das Manöver links abbiegen vorgegeben. Nehmen wir jetzt an, dass diese blaue Trajektorie geplant wurde.

Eine Trajektorie enthält zusätzlich zum Pfad, dem das Fahrzeug folgen soll, auch die Information, zu welchem Zeitpunkt sich das Fahrzeug wo befinden soll. Somit enthält die Trajektorie implizit auch Informationen über die Geschwindigkeit und Beschleunigung des Fahrzeugs. Auf der linken und rechten Seite sind zu dieser Trajektorie der zeitliche Verlauf der Orientierung und der Geschwindigkeit beispielhaft dargestellt. Der orange Punkt in diesen Graphen stellt den aktuellen Zeitpunkt dar. Das Fahrzeug führt anschließend den Abbiegevorgang entlang der Trajektorie aus.

Anschließend wird die nächste Trajektorie geplant, die in diesem Beispiel der Straße folgt.

In der Realität findet die Neuberechnung der Trajektorie deutlich schneller, etwa im Bereich von $50-200ms$, statt und startet immer an der aktuellen Position des Fahrzeugs.

Aktuell sind vorwiegend drei unterschiedliche Methoden in der Trajektorienplanung im Einsatz.19 Da wäre zum einen eine Sampling basierte Trajektorienplanung. Bei dieser Methode werden mehrere mögliche Trajektorien generiert, meist unter Verwendung eines grafenbasierten Verfahrens. Die letztliche Auswahl der zu fahrenden Trajektorie erfolgt dann über eine vorab definierte Kostenfunktion, bei der die beste Trajektorie ausgewählt wird.

Eine andere Methode zur Trajektorienplanung ist die Path-Velocity Decomposition. Hierbei werden das zu fahrende Pfad- und das Geschwindigkeitsprofil des Fahrzeugs getrennt berechnet, wobei zuerst der Pfad und anschließend das Geschwindigkeitsprofil berechnet wird. Problematisch ist diese Form der Trajektorienplanung bei dynamischen Objekten, so ist etwa ein sicherer Überholvorgang mit dieser Art der Trajektorienplanung nur schwer zu realisieren.

Aktuell sind Model Predictive Control basierte Trajektorienplanungen Stand der Technik. Hierbei wird eine Optimierung anhand einer Kostenfunktion durchgeführt, in der die Umgebung und die Kinematik des Fahrzeugs einfließen. Im Vergleich zu den beiden anderen Methoden ist Model Predictive Control meist komplexer in der Formulierung und Berechnung des Problems. Entsprechend gute Hard- und auch Software ist daher zwingend notwendig.

Aktorik

Ist die Trajektorie geplant, so müssen für dessen Ausführung die entsprechenden Befehle an die Aktorik erfolgen. Bei Aktuatoren handelt es sich meist um Elektromotoren oder elektromagnetische Ventile, die in der Motorsteuerung und in Komfortsystemen zum Einsatz kommen.20 In unserem Fall sind vorwiegend die Aktuatoren zur Beschleunigung, zum Abbremsen oder zum Lenken des Fahrzeugs entscheidend, die das Fahrzeug entlang der geplanten Trajektorie fahren lassen.

Um die korrekten Signale an die Aktorik zu ermitteln, sind noch ein paar Zwischenschritte notwendig. Betrachten wir einmal die folgende Situation mit der geplanten blauen Trajektorie, wobei zur besseren Übersicht das Fahrzeug verkleinert wurde. Zudem wird ein etwas größerer Abstand zwischen dem Fahrzeug und der geplanten Trajektorie angenommen.

Zur Bestimmung der gewünschten Werte für die Aktuatoren wird der nächste Punkt auf der Trajektorie in Bezug zum Fahrzeug bestimmt, hier dargestellt durch den roten Punkt. Anschließend wird der Abstand zwischen dem roten Referenzpunkt auf der Trajektorie und der Position des Fahrzeugs berechnet, hier gekennzeichnet mit $\Delta s$. Zudem wird die Orientierung $\theta_c$ und die Orientierung der Trajektorie $\theta_t$ am Referenzpunkt bestimmt. Die Differenz dieser beiden Werte bezeichne ich mit $\Delta \theta$. Zusätzlich wird die Differenz in der Geschwindigkeit $\Delta v$ bestimmt.

Alle diese Werte und je nach Methodik noch weitere dienen als Input zur Bestimmung der gewünschten Beschleunigung $a$ und des Lenkwinkels $\phi$, um das Fahrzeug entlang der Trajektorie zu leiten. Rechts unten in der obigen Abbildung sind diese einmal als zeitlichen Verlauf für $a$ und $\phi$ dargestellt, in der Regel werden $a$ und $\phi$ aber nur als einzelne Werte in sehr hoher Frequenz von wenigen Millisekunden berechnet. Die Berechnung ist nämlich meist nicht sehr komplex und kann daher in rascher Folge durchgeführt werden. Man bezeichnet dieses Modul als High-Level-Controller.

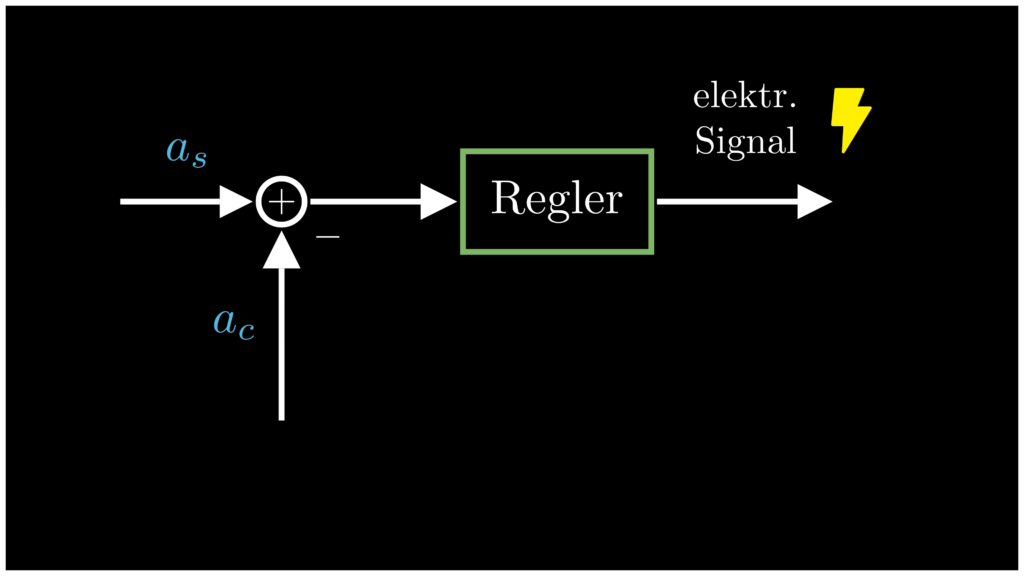

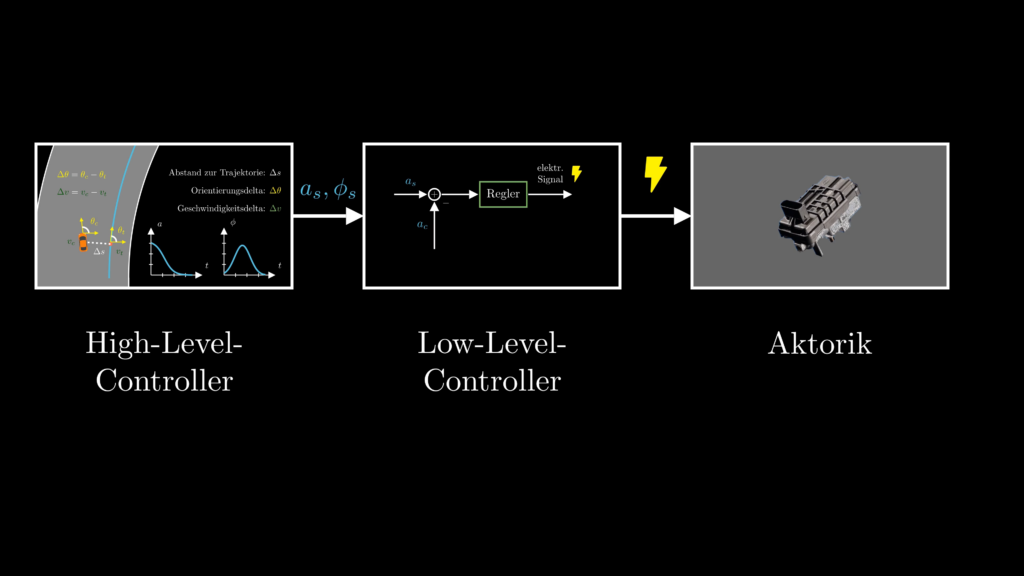

Wir haben nun also Sollwerte für die Beschleunigung $a_s$ und $\phi_s$ welche als Input für den sogenannten Low-Level-Controller dienen. Im Low-Level-Controller betrachten wir einmal beispielhaft die Sollbeschleunigung $a_s$, auf der linken Seite der unteren Abbildung.

Hinzu kommt die aktuelle Beschleunigung des Fahrzeugs $a_c$, welche von $a_s$ subtrahiert wird, in der obigen Abbildung dargestellt durch das kleine Minus. Letztlich wird hier also die Differenz zwischen $a_s$ und $a_c$ gebildet, welche als Input in einen Regler läuft. Dieser Regler dient zum einen dazu, einen sanften Übergang zur gewünschten Beschleunigung zu erreichen und zum anderen die gewünschte Beschleunigung in ein elektr. Signal umzuwandeln, welcher als Eingangsgröße für den Aktuator dient. Dieses Vorgehen des Low-Level-Controllers kann analog mit dem Lenkwinkel $\phi$ durchgeführt werden.

Damit ist die Kette zwischen dem Wahrnehmen der aktuellen Fahrsituation durch die Sensorik, hin zu den ausführenden Elementen im Fahrzeug, der Aktorik, abgeschlossen.

Zusammenfassung autonomes Fahren

Damit sich ein Fahrzeug autonom auf der Straße bewegen kann, sind sehr viele Hard- und Softwarekomponenten notwendig, die exakt aufeinander abgestimmt sein müssen, um eine sichere und reibungslose Fahrt zu ermöglichen. In jedem dieser Bereiche wird sehr viel Forschungsarbeit investiert, einen Teil dieser Arbeiten findet ihr hinter den angegebenen Fußnoten.

Dies beginnt bei der Sensorik, die das Umfeld des Fahrzeugs erfassen, geht dann über die Bestimmung des Fahrzeugzustands und das Erstellen des Umfeldmodells. Diese beiden Größen sind der Input für die Bewegungsplanung, die in viele kleine Teilmodule aufgeteilt ist, wie die Navigation, die Führung und die Trajektorienplanung. Die geplante Trajektorie dient dann als Input für die Aktorik, wobei die nötigen Stellgrößen erst in elektrische Signale umgewandelt werden müssen.

Neben den hier angesprochenen technischen Herausforderungen bestehen auch weitere Fragestellungen, etwa hinsichtlich ethischer Aspekte und der Absicherung der Software nach außen. Auch bürokratische

Herausforderungen gilt es zu bewältigen.22 Es wird also mit Sicherheit noch einige Zeit vergehen, bis sich Fahrzeuge wirklich vollkommen autonom auf (deutschen) Straßen bewegen werden.

Weitere Informationen

In meinen Videos auf YouTube stelle ich dieses und weitere Themen aus den Bereichen Programmierung und Machine Learning noch einmal detaillierter vor. Bei Fragen oder Anmerkungen schreibt mir gerne einen Kommentar :).

Falls dir dieser Beitrag gefallen hat und du meine Arbeit gerne unterstützen möchtest, schau daher doch einmal auf meiner Support-Seite vorbei. Das würde mich sehr freuen :).

Bildquellen

Die Bilder wurden von mir selbst mithilfe der Python Bibliothek manim erstellt. Ich verwende dort jedoch einzelne Elemente, wie Autos und Bäume, die aus anderen Quellen stammen, welche ich hier angebe.

Bilder Auto, Bäume, Fußgänger: Freepik, https://de.freepik.com

Bild Satellite, Funkturm, Fahrrad, Blitz: FlatIcon, https://www.flaticon.com/

- In Anlehnung an Automotive Engineers (Taxonomy and De nitions for Terms Related to Driving Automation Systems for On-Road Motor Vehicles J3016 201806.) 2018, Link. [↩]

- Vgl. Ackerman (Toyota’s Gill Pratt on Self-Driving Cars and the Reality of Full Autonomy) 2017, Link. [↩]

- In Anlehnung an Matthaei, R.; Maurer, M. (Autonomous driving – a top-down-approach), 2015, Link. [↩]

- Vgl. Yeong, D.J.; Velasco-Hernandez, G.; Barry, J.; Walsh, J. (Sensor and Sensor Fusion Technology in Autonomous Vehicles: A Review) 2021, Link. [↩]

- Bildquelle Short-Range Radar: Link. [↩]

- Bildquelle Long-Range Radar: Link. [↩]

- Videoquelle Visualisierung von Radardaten im Straßenverkehr: Link. [↩]

- Bildquelle Kamera autonomes Fahren: Link. [↩]

- Bildquelle Velodyne-LiDAR-Sensor: Link. [↩]

- Videoquelle Visualisierung von LiDAR-Daten im Straßenverkehr: Link [↩]

- Bildquelle Ultraschallsensor: Link. [↩]

- Bildquelle IMU: Link. [↩]

- Vgl. magicmaps.de (Präzise GPS-Messungen mit Hilfe von DGPS und RTK), Link [↩] [↩]

- Vgl. Rehrl und Gröchenig (Evaluating Localization Accuracy of Automated Driving Systems), 2021, Link. [↩]

- Vgl. Gottschalg et al. (Comparison and Evaluation of Integrity Algorithms in Automated Driving) 2021, Link. [↩]

- European Global Navigation Satellite Systems Agency (Apportionment of GNSS in Automated Driving and integrity requirements for road safety critical applications), 2019, Link. [↩]

- Vgl. Qu et al. (Landmark based localization in urban environment) 2017, Link. [↩]

- Bildquelle Objektdetektion: Link [↩]

- Vgl. Qian, Navarro et al. (Motion planning for urban AD) 2016, Link. [↩]

- Mein Autolexikon (Aktuatoren), Link. [↩]

- Bildquelle Aktuator: Link [↩]

- bussgeldkatalog.de (Autonomes Fahren: Zukunftstechnologie mit Fallstricken), 2023, Link [↩]